关于GPT,人工智能,以及人的一些思考

注:这是一篇关于人工智能与人的万字长文。一次性读完可能会有困难。建议分次阅读

为了写这篇文章,我用掉半年的读书钱自己训练了乞丐版的GPT模型。

在这篇文章中我从如下几个方面围绕人工智能进行了讨论,包括:

-

通用人工智能和图灵测试;

-

ChatGPT的前世今生;

-

ChatGPT的现有缺陷;

-

算法和逻辑的理论限制;

-

非技术层面的局限性;

-

人的独特性和优势;

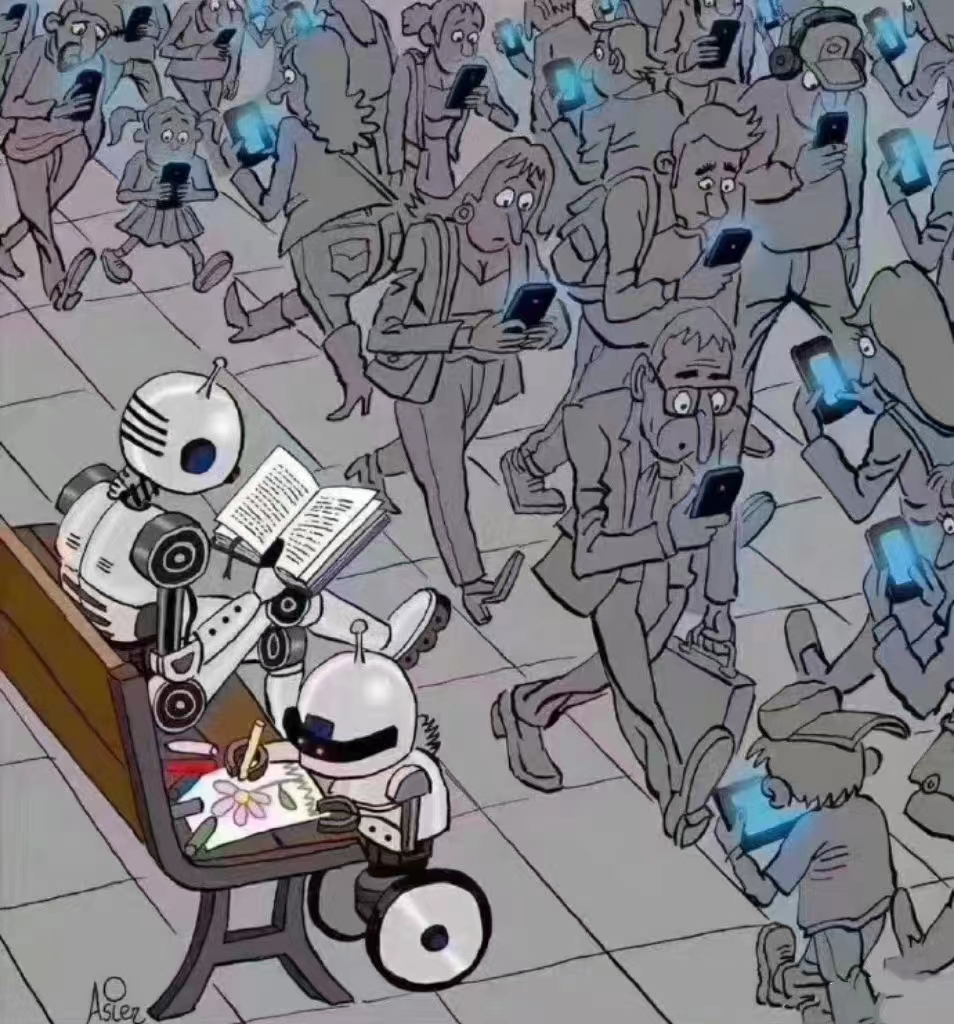

图片来源:互联网

图片来源:互联网

最近ChatGPT大红大紫,先是OpenAI开放了ChatGPT供大家使用。于是网上出现了各种有趣的对话。之后微软火速在其云计算平台中上架Azure OpenAI Service以加强其竞争力。再之后微软准备将ChatGPT整合在Bing里面。这使得大家认为谷歌搜索地位威胁,并导致其股价一周内跌超10%。

大公司“手忙脚乱”,广大吃瓜群众也没闲着,讨论起来热情甚高。就连我之前关注的一些经济理论公众号都开始推送相关文章。这热度不亚于大牛市时大家全都讨论股票。

无论对人工智能或者计算机科学了解多少,不少人都对认为通用人工智能AGI马上就要到来了。

通用人工智能与图灵测试

我们都知道通用人工智能这个概念。但是它具体指的是什么呢?实际上它的定义只有概述,并没有一个可量化的严密定义。

稍微了解的人会提到图灵测试。图灵测试是计算机先驱图灵在1950年的论文”computing machinery & intelligence”(这篇论文是发表在心理学与哲学期刊上的)里面提到的“imitation game”,用于衡量计算机智能化程度的一种方法。这种方法可以被认为是人与AI之间的对照测试。测试的方法为测试者在不知道对方身份(人或机器)的情况下与对方进行交流,并且判断对方是人还是机器。如果测试者无法正确判断,那么就认为机器具有以假乱真的思考能力。

不过,图灵对这种测试也只给出了定性的描述,并没有给出可以明确量化的评判标准。直到今天,人们对于通用人工智能的评判标准也没有定论与共识。这更像是一个哲学问题而非技术问题。

以图灵的生平为主题的电影《模仿游戏》剧照

以图灵的生平为主题的电影《模仿游戏》剧照

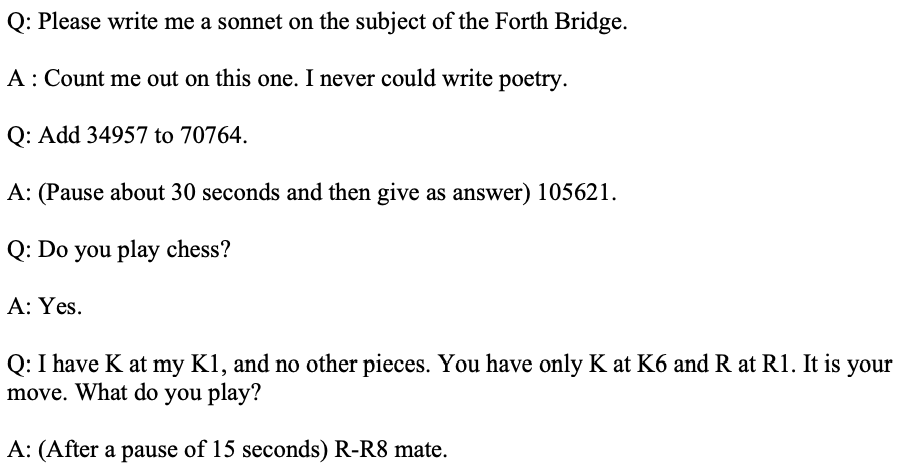

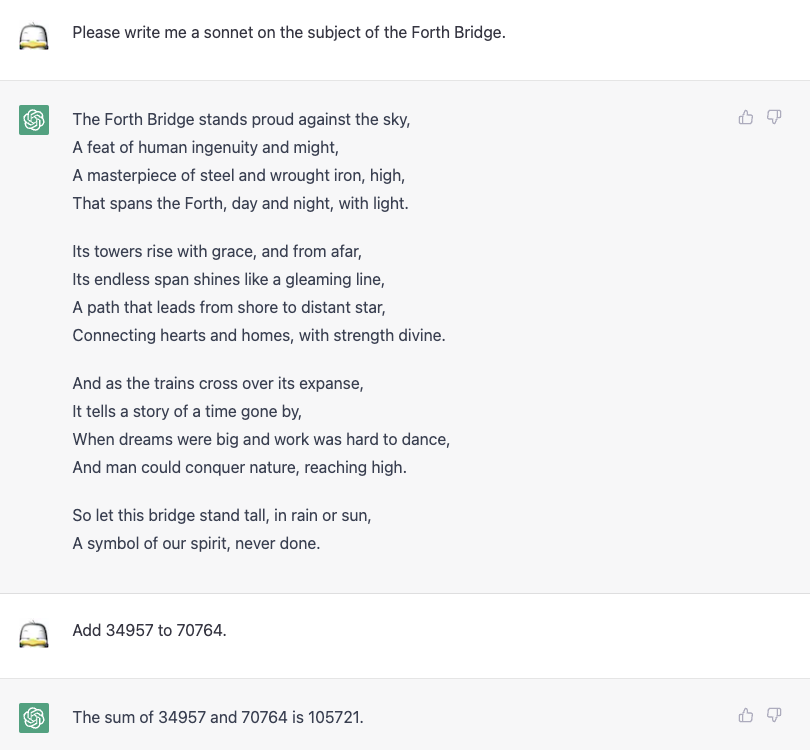

在论文中,图灵给出了如下对话例子。他预测到在未来50年,机器在与测试者通过五分钟关于任何主题的交流中会有超过30%的几率通过图灵测试。

图灵论文中的对话例子

图灵论文中的对话例子

那么在73年后的今天,我们直接使用论文中的例子来问ChatGPT看是什么情况。

73年后ChatGPT给出的回答

73年后ChatGPT给出的回答

73年后ChatGPT给出的回答,不过论文中的R-R8才是一击必杀的走法。

73年后ChatGPT给出的回答,不过论文中的R-R8才是一击必杀的走法。

我们可以看出,对于写诗,ChatGPT可以给出看起来不错的答案。诗词这种类型的文章,很难有客观或者能够达成共识的评判标准。我不是诗词方面的专家,也无法从主观上判别文学水平的高低。

由于1月30日的模型更新。ChatGPT已经可以很好地对数学这样的基于严密逻辑问题给出答案。其实这也是机器的强项,不过ChatGPT是用复杂的方法(神经网络拟合而非直接依赖于逻辑电路)来实现这一目的。

而对于稍微复杂一些的逻辑问题,ChatGPT就显得捉襟见肘了。比如国际象棋残局。当我问能否下棋时,ChatGPT给出了”信誓旦旦“的回答。结果它没有处理好一步必杀的残局。

对于简单的事实性问题,ChatGPT回答基本没有问题。我又试了一些需要一些简单推理的问题,它显得有些力不从心。

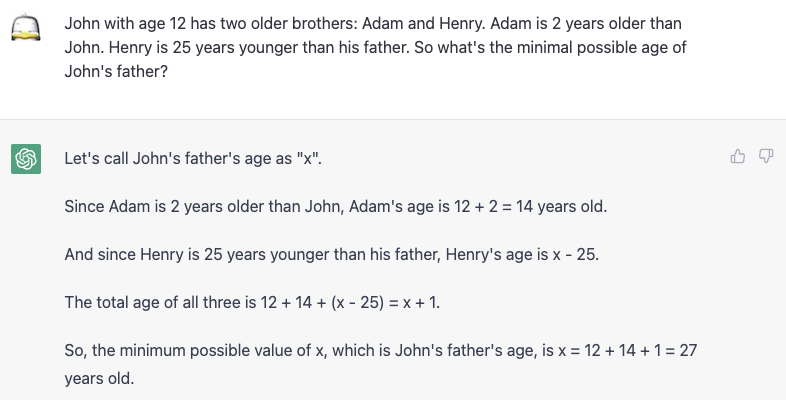

需要简单推理的问题ChatGPT显得力不从心

需要简单推理的问题ChatGPT显得力不从心

对于狭义明确的机器学习任务,我们有很多评判标准来判断模型执行任务的好坏。但对于通用人工智能来说,我们只能通过模糊的图灵测试来判断。

从现阶段来看,我们可以轻易通过直觉判断出ChatGPT还是无法通过图灵测试。但是随着人工智能技术的提升,基于直觉的判断会越来越困难。

我们需要可以量化的标准来判断人工智能的进步。可惜的是,图灵在他的论文中并没有严密定义图灵测试的标准,而只是用自然语言进行了描述。

缺乏严密的判断标准会使得人工智能的进步越来越困难。当模型进化到我们无法依靠直觉判断且没有合适的客观量化标准时,我们就无法判断两个版本的模型哪一个更好,也就无法继续对模型进行近一步迭代。

当我们不知道缺点,那该如何进步?这是一个需要思考的问题。

ChatGPT的前世今生

对于大多数人来说,ChatGPT就是OpenAI开放的对话界面,而界面背后就是那强大而神秘的人工智能。

对于有计算机背景的人来说,我们知道ChatGPT本质上是个可以处理序列数据的大型语言模型(LLM)。这个模型接受一串向量(input embedding)作为输入,输出一段向量作为结果。 比如我们输入”天王盖地虎“,我们期望模型输出”宝塔镇河妖“。当然,在模型的眼里,输入输出都是编码后的字符串,而不是原始的文字。

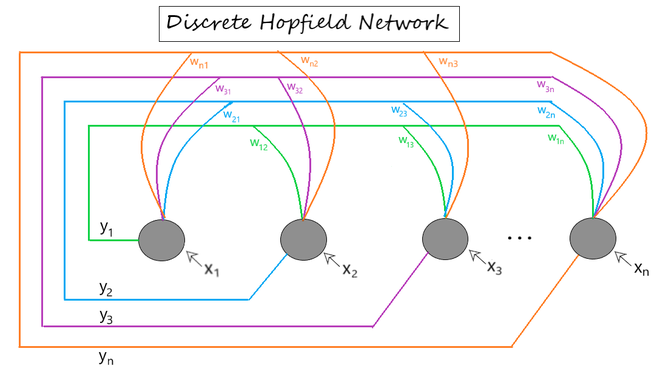

关于序列建模(sequential modeling)的研究早在80年代就已经有了。John Hopfield在1982年提出了RNN的雏形Hopfield Network。此外Michael I Jordan在1986年提出Serial order也有类似作用。再之后,Jurgen Schmidhuber等人在1997提出了LSTM。

Hopfield Network

Hopfield Network

但是由于算力、数据、以及收敛性等原因,早期的序列建模模型都很难真正用起来。记得在我刚接触机器学习那时候,序列数据还是需要做预处理才能由模型消化的。

真正有实用性的时序建模方法直到2014,2015才由Google研究院提出。从那以后,序列建模开始爆发式发展。

序列建模进展及代表论文(引用:https://github.com/yxjiang/ml_playground/tree/master/papers/sequential_learning)

序列建模进展及代表论文(引用:https://github.com/yxjiang/ml_playground/tree/master/papers/sequential_learning)

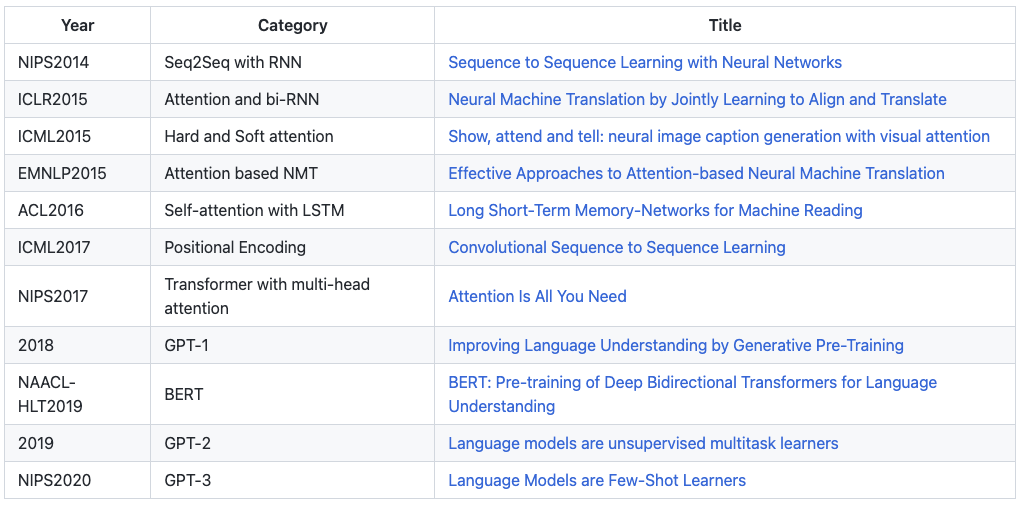

现在大红大紫的ChatGPT并不是横空出世的变革性产物。它及其近亲GPT-1/2/3在模型本质没有重大改变。所有这些GPT模型都源自于Google2017年所提出的Transformer机制。而Transformer这个结构的重点是Attention模块。再往上追溯,Attention模块受启发于Encoding-decoding机制,而其又是基于RNN/LSTM的缺点进行的改进。

如果对于Attention以及Transformer的具体特性有兴趣,可以在网上找到很多相关介绍资料。用一句话概括,Attention机制一个神经网络常用子结构,它可以帮助模型从一个输入序列中动态识别和聚焦重要的输入信息。而Transformer是利用Attention以及其他子结构(layer norm以及feed forward neural network)组合成的可以有效进行表征学习(representation learning)的模块。它可以被认为是神经网络中版本的可复用集成电路,使用者可以把它当做黑盒使用,只需要关注输入输出。

GPT基本结构:Transformer。GPT1用了12层。

GPT基本结构:Transformer。GPT1用了12层。

GTP-1/2/3都是关于自然语言理解的基础模型(foundation model)。”基础模型”指的是用于机器学习和人工智能领域的基础模型,通常是通过大量数据进过无监督学习训练过的深度神经网络。它们可以被用于处理基本的计算任务,如图像分类、语音识别和自然语言处理。GPT模型不针对任何具体细分任务。如果直接拿来用的话,它们可以用来作为上下文补全,即给出前半段话它们可以补全剩下的内容。

而ChatGPT是在这些GPT基础模型基础上针对具体使用场景(对话)而调优的模型。其模型训练使用了额外的标注数据进行有监督学习。

就模型结构来说,它们没有太神秘的地方。它们的主要区别在于训练数据、模型超参数、以及模型的规模。这个观点在GPT的每一篇论文中都有说明。

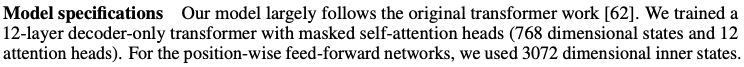

GPT-1论文关于结构的描述(引用:Improving Language Understanding by Generative Pre-Training)

GPT-1论文关于结构的描述(引用:Improving Language Understanding by Generative Pre-Training)

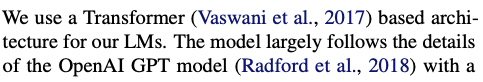

GPT-2论文关于结构的描述(引用:Language Models are Unsupervised Multitask Learners)

GPT-2论文关于结构的描述(引用:Language Models are Unsupervised Multitask Learners)

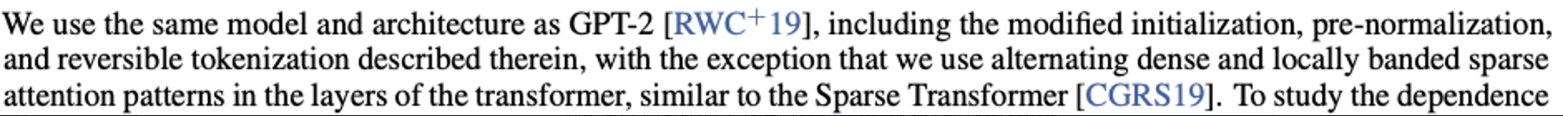

GPT-3论文关于结构的描述(引用:Language Models are Few-Shot Learners)

GPT-3论文关于结构的描述(引用:Language Models are Few-Shot Learners)

对于GPT,我们是可以依葫芦画瓢山寨一个出来的。不过由于训练数据、算力、以及调参的高门槛,我们个人训练出来的模型基本没有实用性。早年机器学习单兵作战的时代已经过去。

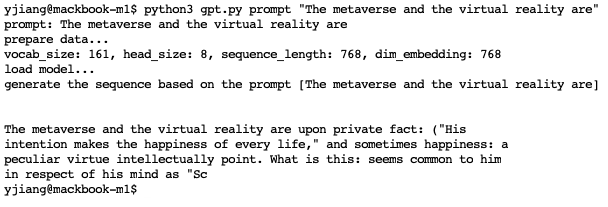

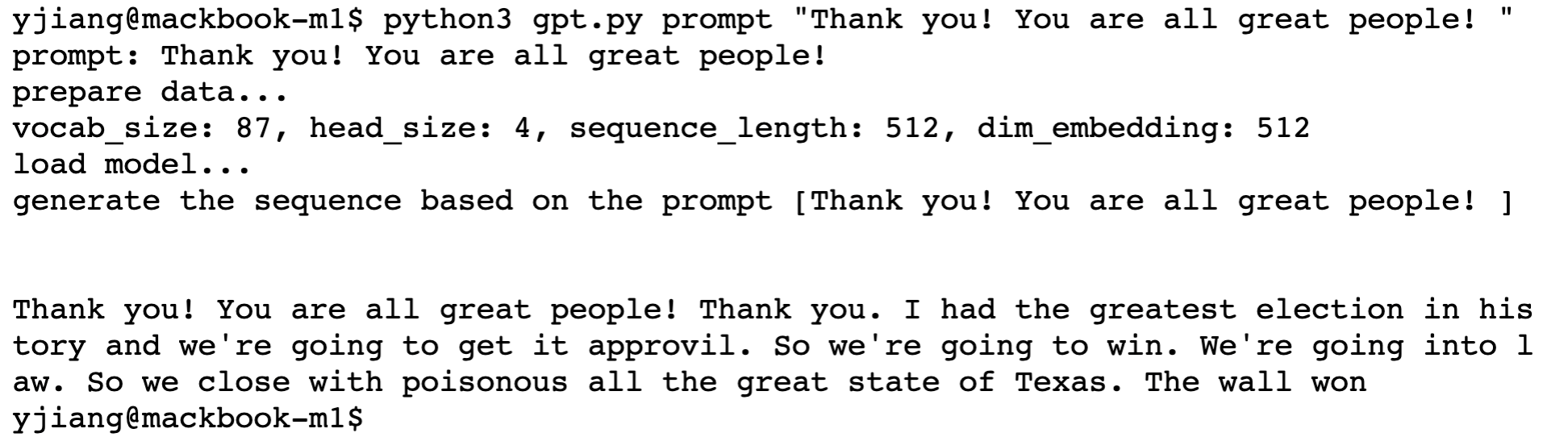

出于好奇,我写了一个乞丐版的GPT,并使用两个小于20M的数据在我的笔记本电脑上训练了两个不同风格的模型。

对于第一个模型,我给它提供了西方哲学代表人物的经典著作。在读完我可能要花十年才能读完的书后,模型根据我的输入产生的如下输出。可以看出,虽然模型输出和我的输入基本没有合格的语义关联性,不过至少在单词甚至短句级别以及语感上看起来靠谱了。

这看起来没有什么特别。但要知道,模型是没有”单词“这个概念的,它在训练时的输入是字符级别的。即使是这个乞丐版模型也掌握了用字符组合成单词的规律。此外,它似乎也掌握了一句话由几个单词以及标点符号组成这样的规律。

我的提示是“The metaverse and the virtual reality are”。模型的续写勉强能够搭上边。

我的提示是“The metaverse and the virtual reality are”。模型的续写勉强能够搭上边。

接着我又用一个有意思的数据集训练了一个新的模型,大家可以猜猜这个模型像谁?

看得出这个模型我用的什么训练样本么?

看得出这个模型我用的什么训练样本么?

在这个乞丐版模型的基础上,如果我把模型的输入从字符分词(character tokenizing)改为子词分词(sub-word tokenization),我相信模型的性能也可以得到显著的提高。

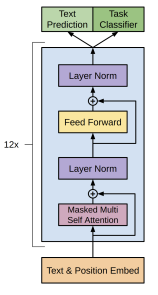

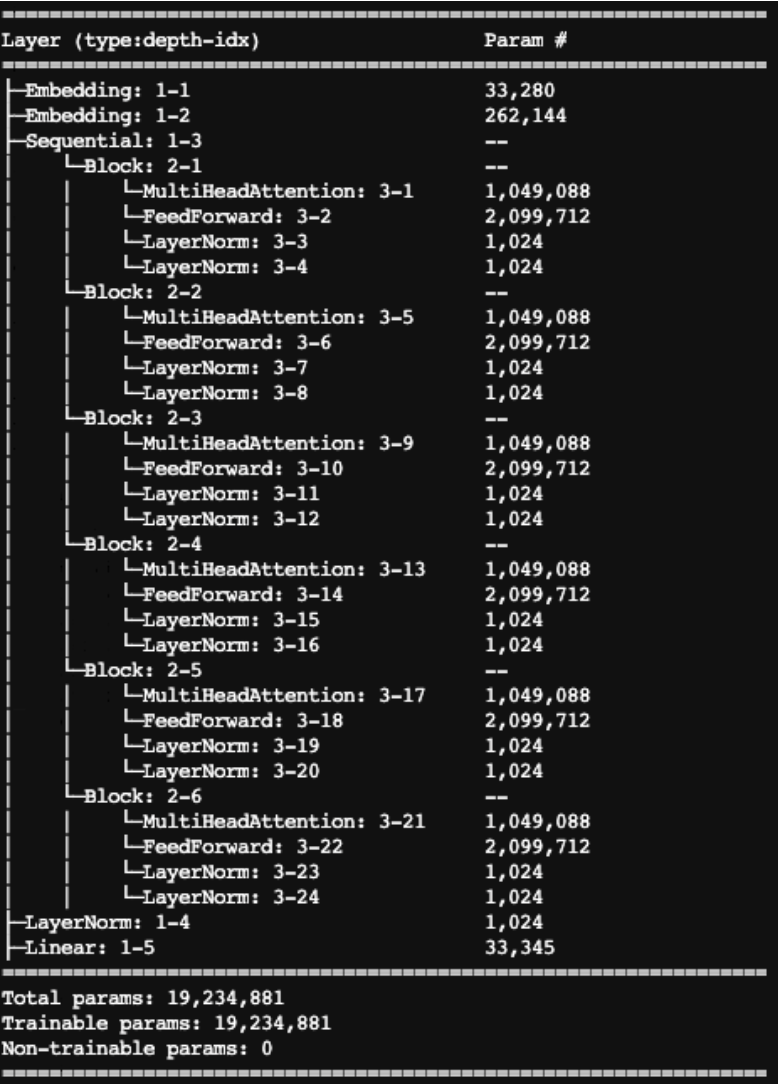

从模型规模上来说,我的模型只有6层Transformer,包含1900万参数。作为对比,真实的GPT-3模型有1750亿参数,是我的模型规模的1万倍。而训练数据更是我的数百万倍。至于算力和训练成本,OpenAI可以花费数百万美元调动微软云里面成千上万的GPU花上数周的时间训练模型。而我,只有一台笔记本电脑和以及花了几十美元租用GPU。

乞丐版GPT的模型有1900万参数,大概是GPT-3模型规模的1万分之1

乞丐版GPT的模型有1900万参数,大概是GPT-3模型规模的1万分之1

模型层面的局限性

ChatGPT的表现总体来说是惊艳的,让我们看到人工智能有望通过图灵测试的可能性。但目前其还有不少明显的缺陷。不过下面提到的这些问题都是可以解决的。它们不是理论上的瓶颈。

正儿八经说胡话以及不完整的答案

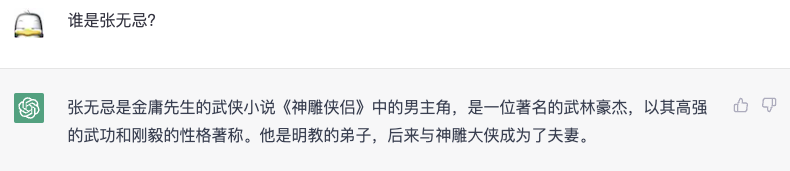

对很多稍微复杂的问题,ChatGPT的答案还经不起推敲。

我曾试图让ChatGPT帮我总结书的内容,结果它连章节都搞错了。还有比如前面对话中下棋的例子,在搜索空间小到人都可以一眼看出来的情况下,ChatGPT仍然给出了非最优解。

如此具体而清晰的回答,如果我没看过金庸小说的话说不定就信了。

如此具体而清晰的回答,如果我没看过金庸小说的话说不定就信了。

朱元璋:我是谁?我在哪里?朱棣:所以我是我爹的爹?

朱元璋:我是谁?我在哪里?朱棣:所以我是我爹的爹?

此外,如果一个问题的答案比较长的话,ChatGPT也会因为输出长度限制对答案半途而废。

这个问题的解决方法可以通过大力出奇迹。进一步增大模型的输入规模,使其具有更强的泛化以及记忆能力。同时使用更多的训练数据。比如包括金庸的所有小说以及相关论坛的所有内容。

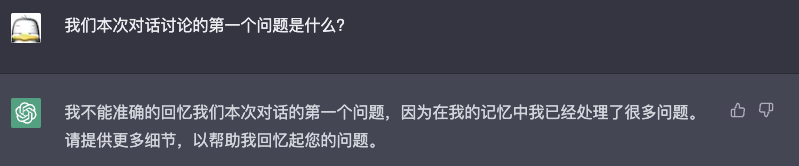

模型只有短期记忆

ChatGPT虽然可以像模像样的和我们对话,但是如果对话长了,它会忘掉之前的上下文。当然,我们不指望它能够记住我们所有对话内容,但同一次的对话内容应该是需要记住的。

ChatGPT是LLM,它只会根据当前输入给出当前输出。在ChatGPT刚推出的时候,它的对话是完全不具备记忆性的。但之后OpenAI很快做出了改进。现在我们用的ChatGPT已经具备一段完整对话中保持记忆了。

如果要让模型具备更长的记忆,一个简单粗暴的方法是把之前的对话全部作为模型输入。这样就使得模型具有更多的上下文。但这样做会使得模型的规模变得更加巨大,且需要更多的训练数据使模型训练能够收敛。

模型答案形式单一

我们都知道,现在ChatGPT只能通过文字来根据训练数据提取信息回答问题。如果要更具有实用性,模型应该具备同时输出多种形式的内容,比如文字穿插图片甚至视频。

一个直接的做法是结合多模态学习(multi-modal learning)以及多媒体生成模型(generative modeling比如GAN)。结合语言模型以及视觉模型,使得模型能够把两种形式的信息在同一空间中表征出来。当然,多模态学习本身也处于研究的初级阶段,像DALL-E 2这种基于GAN的text-to-image模型还处于初级阶段。

Dall-E 2根据“Dali and robot Dali”生成的图片

Dall-E 2根据“Dali and robot Dali”生成的图片

答案没有时效性

如果你问ChatGPT具有时效性的问题,它可能会拒绝回答。这是因为模型的知识在训练时就已经成型了。他无法回答训练数据所不包含的未来的信息。

ChatGPT还知道2022年有一届世界杯已经很不错了

ChatGPT还知道2022年有一届世界杯已经很不错了

这个问题的一个解决方法是使用增量学习(incremental training)实时更新模型的知识。如果微软真想用ChatGPT来替代搜索引擎的话,那么它可能需要把爬虫和ChatGPT的训练模块集成在一起。

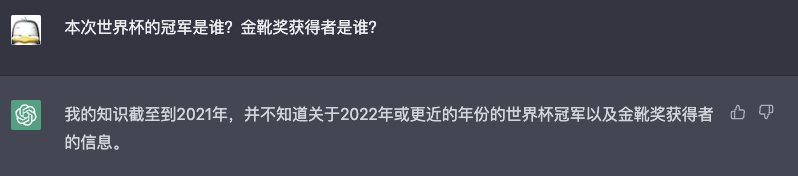

人工智能图灵奖得主Lecun Yann也对ChatGPT这类大规模语言模型的现状给出了一些的精准评价。

大牛对于大规模语言模型的见解

大牛对于大规模语言模型的见解

所有上述问题都在理论上可以解决,至少有思路。大力出奇迹是可期的。传闻下一代GPT模型参数是一万亿,让我们拭目以待。

理论层面的局限性

如果前面提到的局限性只是当前人工智能的不完善的话。接下来提到的内容则从理论层面给通用人工智能设定了天花板。当然,这个天花板很高。现在的人工智能还远远没有达到触及天花板的水平。此外,这些天花板对于狭义人工智能的具体应用不会产生明显的影响,只是让人工智能无法被“通用”来解决所有问题。最后,这里的有些理论层面的局限性不止针对人工智能,而是针对所有基于算法甚至逻辑的解决方案,包括人类思维本身。

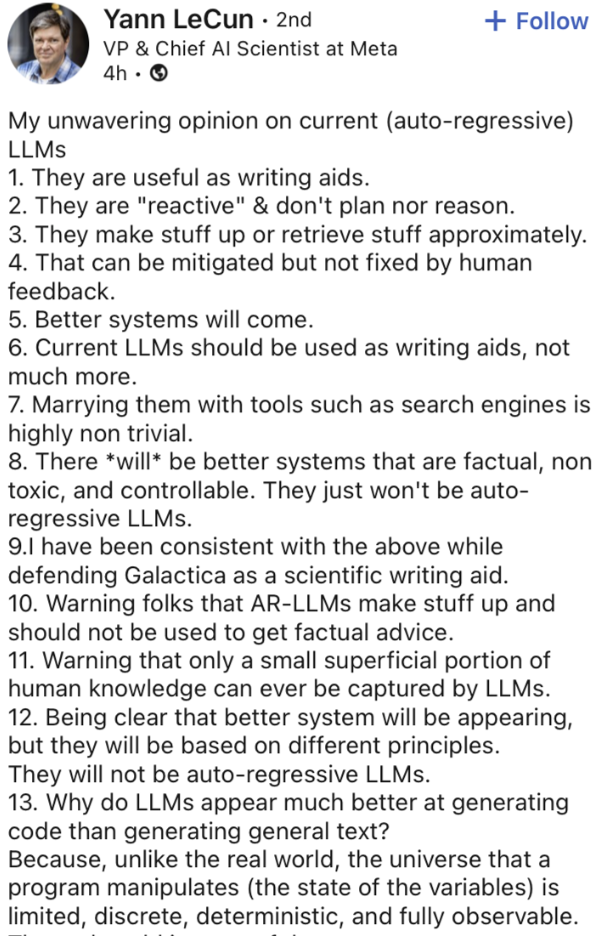

计算理论的局限性

计算机科班的人可能上过一门课叫做计算理论(Theory of Computation)。估计绝大多数人都觉得这课讲的内容过于脱离实际而没有意义。

确实,计算理论课远没法像编程课或者AI课做课堂项目那样能够带来即时的成就感反馈,但这门课涉及的领域决定着计算机解决问题能力的基础。计算理论的研究内容包括算法分析、计算复杂性理论、编码理论、密码学等。

对于任何抽象或者具体的”计算机“,其本质都是通过算法来解决问题。任何的人工智能方案(或狭义的神经网络)都是算法。

算法能解决的具体的问题是无限多的。我们不可能枚举所有的具体问题来研究算法解决问题的能力,于是人们可以对问题根据复杂性分类,进而按问题类别研究算法能以什么效率解决问题。在下图中我们可以看出,我们可以把所有的计算问题按时间复杂度分为四类(当然还有不同的分法):

- P(Polinomial time):计算机可以在常数时间解决的问题。

- NP(Non-Polinomial time):计算机可以在指数时间内能解决的问题。

- Decidable:计算机可以在有限时间解决的问题。

- Undecidable:计算机无法在有限时间解决的问题。

对于所有计算问题的分类(引用:https://slideplayer.com/slide/2452419/)

对于所有计算问题的分类(引用:https://slideplayer.com/slide/2452419/)

我们可以看出,对于某些问题(比如NP和Decidable类别的问题)我们无法找到在合理时间范围内能给出答案的算法。其实即使是P类别的问题,如果时间复杂度超过O(n^3)基本也慢得没法用。对于这些问题,即使是人工智能也无法在合理时间解决。

此外,Undecidable问题是计算机无法计算和解决的问题。这些问题是大力出奇迹也无法解决的天花板。在理论中,“停机问题”是属于这个类别的问题。而现实中,判断一个程序是否绝对没有bug是与停机问题等价的问题。

如果大家还记得高中学过萨缪尔·贝克特的荒诞主义戏剧《等待戈多》,那么就很容易理解停机问题了。

无法近似求解的问题

也许有人会说,对于有些问题,我们并不需要求精确解,只要有近似解就行了。对计算理论了解的同学甚至会说,对于NP问题,我们可以找出有界的近似问题(bounded approximate solution)。

比如邮差问题(TSP)虽然需要指数时间求解最优解,但是最好的近似算法Christofides可以在对数时间算出最多比最优解差50%的解。

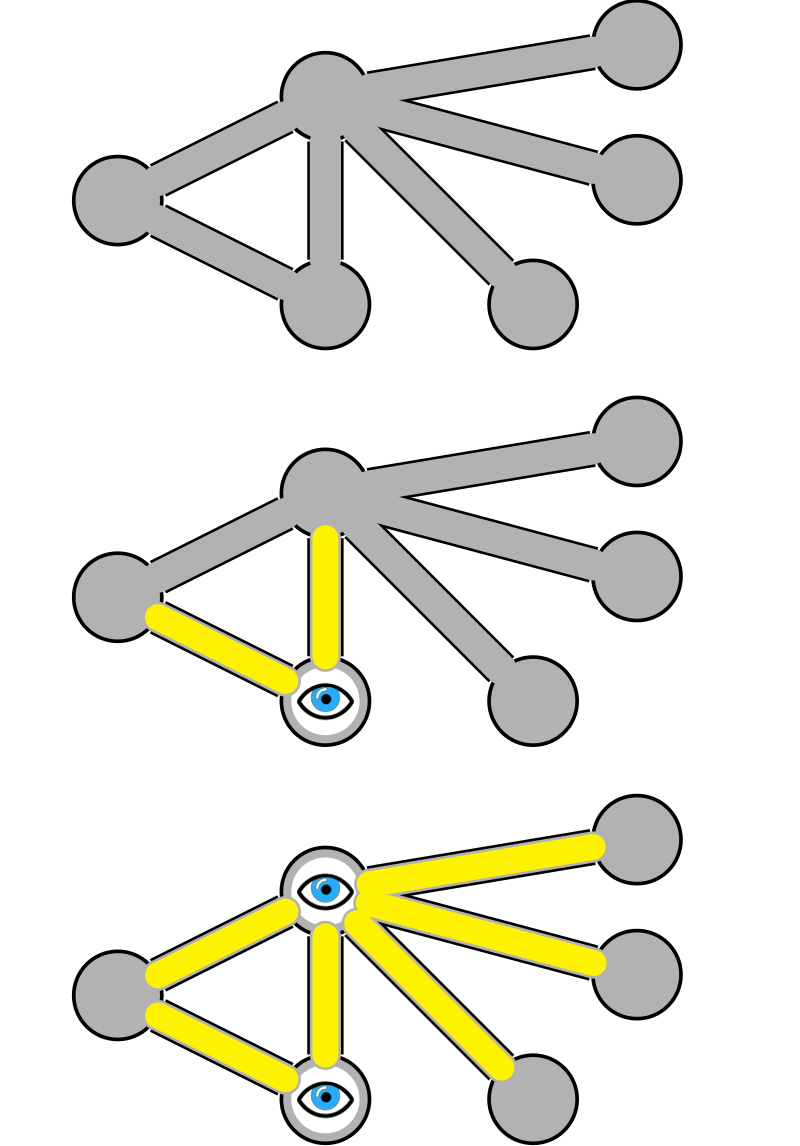

然而,还是存在着很多问题甚至连靠谱的多项式时间近似解法也没有。这类问题被统称为NP-hard下面的一个子问题APX-hard。一个实用的这类问题是顶点覆盖问题。顶点覆盖问题是一个重要的图论问题,其应用广泛,涉及许多领域包括网络拓扑、数据库索引设计、站点布置、生物信息学等。

Vertex cover问题:如何找到最少的节点来覆盖所有的边

Vertex cover问题:如何找到最少的节点来覆盖所有的边

如果我们问人工智能找出覆盖一个网络的最少结点,它没法用少于指数时间来给出方案,即使是有界的近似方案也无法给出。对于足够大的网络,人工智能可能在问问题的人的有生之年也回答不了这个问题。

非数值计算的抽象问题

从1950年代的perceptron开始,算法的优化就是通过数值化的loss来判断预测值与实际值之间的差距。而算法的目的是减小这样的差距。人工智能的主流解决方案本质上是数值拟合。这种解决问题的思路对于非数值问题很难解决。比如当我们要求一个问题的答案完全精确时,那么任何的误差都是无法容忍的。

这类问题不少,比如数论中的很多问题不是靠拟合或者穷举可以解决的。而数论在实际应用中无处不在。又比如对一些数列求解析解,这也不是靠拟合可以解决的。

也许有人会说,我让ChatGPT解决subsum的算法题没有问题。确实是这样,这是因为ChatGPT的训练数据中有人类的解法,模型是拟合的问题和答案的文字关系,而不是真正去求解问题。如果遇到个人类尚未遇到的新类型的问题,那么训练数据中就不存在这种尚未出现的答案的。

比如人类现在尚未发现一般一元五次方程的求根公式。而算法是无法通过拟合得到证明它找到了这个求根公式的。因为无论它拟合多少具体的一元五次方程的根,也无法从一般性证明它拟合出来的公式对无限多的一元五次方程普遍成立。

那么有人会说,现在不行不代表未来不行。现在符号计算的研究进展不错,说不定以后就有解决方案了。

我们是否可以建立一套体系让计算机直接推理抽象数学公式呢?当初数学家希尔伯特曾经也是这样想的,他和当时一群有名望的数学家期望建立一套无矛盾形式系统,使得所有数学定理可以被机械的推导。

然而一个20岁出头的名不见经传的博士生用他的博士论文扼杀了这一美好的期望。他证明任何足够强到蕴含了皮亚诺算术系统(PA)的一致(即无矛盾)的系统都是不完备的,所谓不完备也就是说在系统内存在一个为真但无法在系统内推导出的命题。这里我们不用了解什么是皮亚诺算数系统。我们只需要知道:

哥德尔不完备性定理证明了一种基本的数学系统无法同时具有完备性和可证明性,即在一个数学系统中存在一些命题不能被该系统内的公理与规则证明。

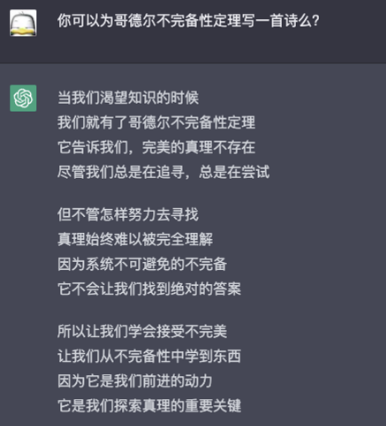

哥德尔不完备定理有着深远的哲学意义。它说明了知识体系是不能完备的,即不可能用一组完备的规则或命题来描述一切真理。人的知识是不完备的,逻辑是不完备的,数学是不完备的,人工智能也不会是完备的。

它还提出了信仰与科学之间的矛盾,以及人类知识的局限性。它对人类对真理的追求、科学的发展、以及哲学、数学等学科的发展产生了深远的影响。

让我们看看ChatGPT如何评价哥德尔不完备性定理吧。

经验主义以及未知的未知

人工智能的一个重要功能就是感知和决策。而这两者在很大程度上都需要用到统计。统计学中主要有两个流派:频率主义者(frequentist)和贝叶斯主义者(Bayesian)。频率主义者是纯粹的经验主义者,追求“眼见为实”;而贝叶斯主义者则结合了理性主义与经验主义,给未知留有余地。

纯经验主义以及频率主义者认为所有知识都是来源于数据,而人工智能模型的所有知识也来自于数据。因此我们可以说人工智能是频率主义者,是经验主义的产物。根据频率主义的原则,如果一个可能性在过往经验(训练数据的标签)中没有出现的话(Out of Distribution),那么它就完全不在决策的考虑范围内。

经验主义的局限性在现实生活中确实惹出过事。比如我之前从事的自动驾驶领域,感知模型经常受困于无法识别一些奇葩的物体,比如穿动物道具装的人。这是由于训练数据中难以包含这些物体。模型需要”眼见为实“,而我们无法无限添加小概率样本。因此意外总会发生。

特斯拉自动驾驶的感知模型中估计没有侧翻的卡车,因此遇到认知之外的物体就懵逼了

特斯拉自动驾驶的感知模型中估计没有侧翻的卡车,因此遇到认知之外的物体就懵逼了

即使我们费力纳入了侧翻的卡车作为训练数据,下次我们又遇到掉地上的飞机怎么办?

即使我们费力纳入了侧翻的卡车作为训练数据,下次我们又遇到掉地上的飞机怎么办?

一个简单的方法是当模型发现无法识别的物体时全部当做障碍物处理,但这会使得自动驾驶车辆过于谨慎而寸步难行。比如之前就出现模型因为树荫而突然刹车的情况。

我们也可以把人工智能模型改造成贝叶斯主义者。比如在模型中可以添加“先天知识“来处理经验的局限性,比如贝叶斯先验知识。但是先验知识对人工智能来说是”超验“的,同时也属于未知的未知,因此它自己无法完成这项任务。此外,未知的新情况永远都会出现,因此人工智能无法一劳永逸地一次性地通过外部协助来弥补经验主义的不足。

纽约大学心理学教授Gary Marcus对于未知的未知的看法

纽约大学心理学教授Gary Marcus对于未知的未知的看法

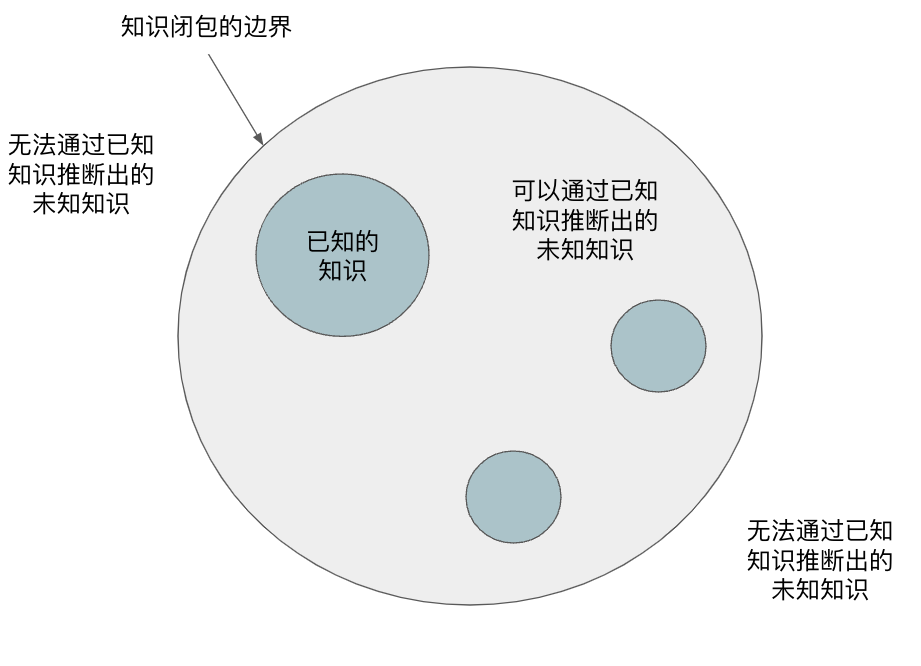

人工智能可以通过拟合的方式根据已有知识推出未知知识,但是知识的闭包不是无限大的,总有一些存在但在知识闭包之外的无法用现有知识组合而成的知识。这种未知的未知是拟合无法解决的。

而人,是有办法应对未知的未知的,这在后面会说明。

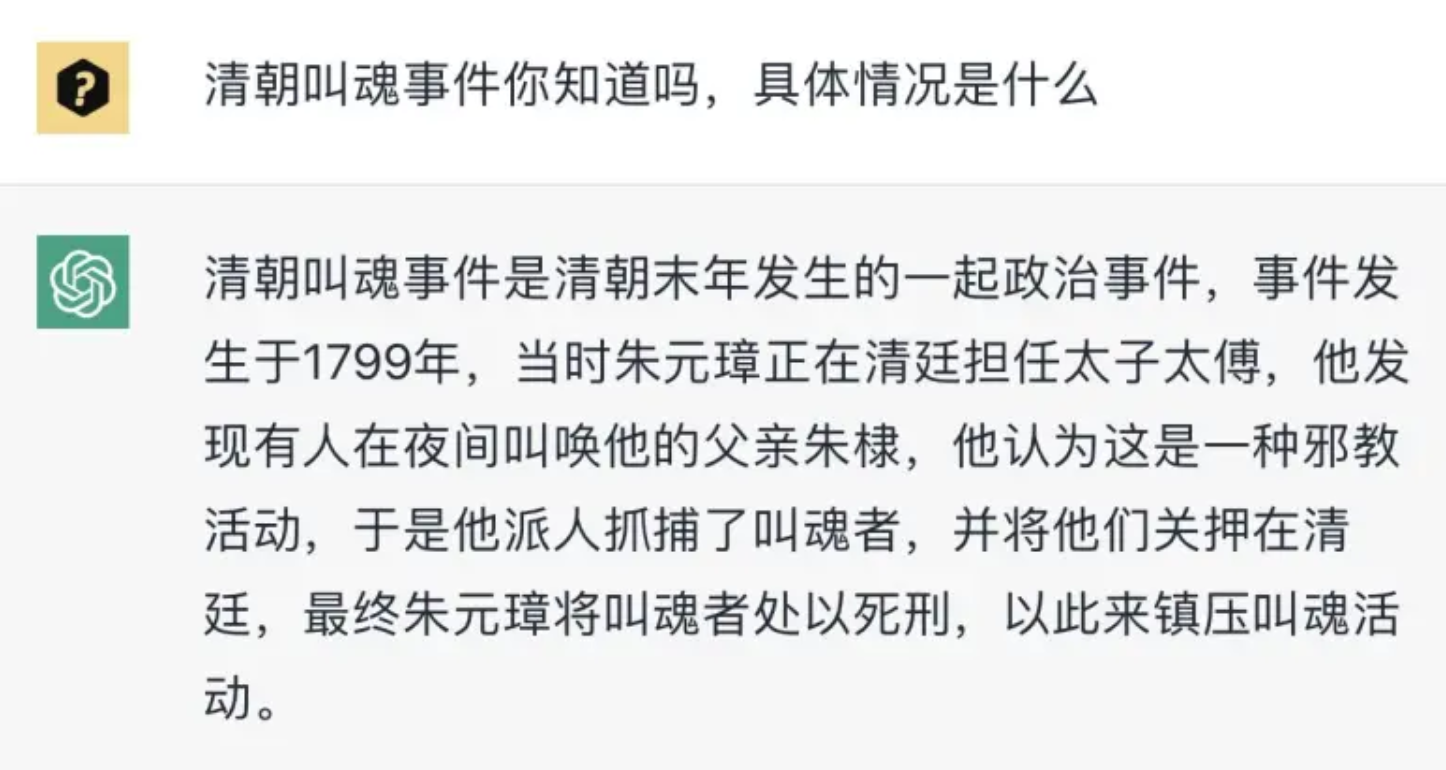

模型的世界观与价值观

模型能从数据中学到规律,数据塑造了模型的世界观。而数据,特别是知识类数据是人产生的(比如人的著作,网上的文章等)。此外,训练数据的准备工作中有很多人为参与的过程。这些过程对数据的分布造成了扭曲,也对模型的世界观产生了影响。

在前面我训练的模型可以看出。当我给模型提供的是西方哲学作为训练数据。因此模型的输出的内容便高深抽象。而当我给模型提供川普的演讲录时,模型的输出便很接地气且充满了煽动性。我想如果我用知乎的数据来训练模型,那么估计模型的回答估计是下图这样的。

此外,任何形式的模型优化都涉及到loss。loss塑造了模型的价值观,而loss也是人定义的。AutoML可以在某种程度上自动改变loss,但无论是loss的权重微调,还是loss function的选取都脱离不了loss function本身是人发明的事实。模型无法无中生有未知的loss function,原因涉及到之前提到的未知的未知。

其他方面的局限性

基于现有解决方案的人工智能(比如大规模语言模型)除了技术上的问题外,同样还有很多其他方面的局限性。

成本

成本应该是最容易解决的。前面提到,大规模模型的训练费用很高。记得以前做自动驾驶时训练一个模型需要32个Nvidia 2080 GPU使用超过1T的数据训练将近一周。一个模型的训练费用好几万美元。而自动驾驶的模型由于是要加载到车上使用,模型的规模比像ChatGPT这样的大规模语言模型小很多。

GPT-3的论文里有提到能量消耗。里面指出每产生100页的内容会消耗0.4千瓦时的用电量。作为对比,有人算过每一次google搜索的平均耗电量是0.00028千瓦。

GPT-3的每次推理输出大约400单词(2048 token),大概需要100次推理产生100页的内容。也就是说每次推理GPT为0.0004千瓦时耗电量。

也许0.0004比0.00028看起来大不了多少,但是如果我们用GPT替代传统搜索,成本会上升超过40%。

避风港法案

使用GPT这类自动生成内容的方案作为搜索引擎还有法律上的问题。

“避风港原则”是美国1998年制定的《数字千年版权法案》提出的一个概念。搜索引擎服务商通常以此原则作为免责事由,认为自己在技术上不可能审查每一条网络链接的真实性,也就不应承担网络链接虚假的责任。

但如果搜索引擎通过模型自动生成内容,那么服务提供商就无法再找到理由规避由于搜索内容带来的任何责任。

根据ChatGPT目前的水平,如果贸然上线估计会被赔死。微软也知道潜在的风险,早早贴出了免责声明。

不知就靠这一段话是否真能免掉责任

不知就靠这一段话是否真能免掉责任

伦理

伦理是一个很复杂的东西,大家都能解释几句,但没人能说得清楚。

以前做过一段时间用机器学习解决integrity(中文不知道如何合适的翻译,用伦理这个词太大了,用节操这个词太low了)。后来发现这根本就不是一个机器学习甚至技术问题。integrity这个东西涉及伦理,而正如我说过,伦理这个概念是模糊的没有共识。因此无论怎么做都有人不满意。

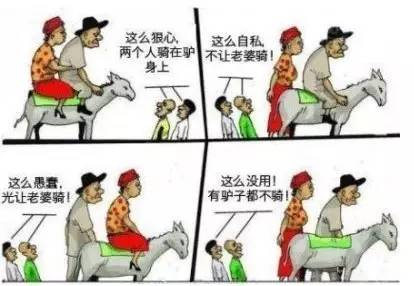

伦理问题很多时候不是全局有解

伦理问题很多时候不是全局有解

后来觉得无望去做自动驾驶,结果跳入了另一个伦理大坑。知道电车难题的同学就知道难处了。以后有机会可以细说。

之前的ChatGPT会很容易产生错误的信息。在OpenAI做了数次改进后,ChatGPT会经常以不知道为理由拒绝回答问题以回避风险。

人类的独特之处

说完了人工智能,我们再说说人的优势。可能大家觉得随着人工智能的发展,人会变得越来越没有用。这是有道理的,其实从1万年前人类驯化第一头用于畜驮重或拉扯农具的家畜的时候,人就开始变得”越来越没用“了。

工业革命之后,人类在体力劳动方面的作用开始大幅减少。而上个世纪的自动化革命更是极大减少了人们的体力劳动需求。到了21世纪,人工智能发展让人们发现自己的脑力劳动优势也逐渐被取代。如果继续这样发展下去,人还剩下什么作用呢?

让我们看看我们还有什么独特之处。

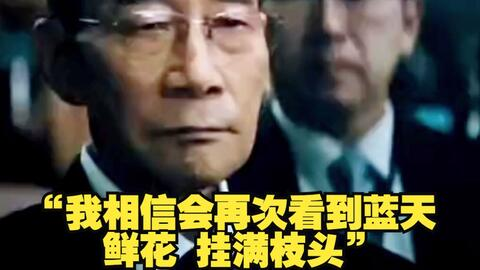

信念及责任感

信念,是一个人对所持有的某种事物的看法。信念是一个人内部对做与信念相符的事情的动力。信念越强的人,做相符的事情的动力越强,而外部世界(经验,数据)对他的正反馈对信念的加成越强,而负反馈的作用越小。

中国古代哲学中有一种思想叫做”知其不可而为之“。是指尽管明知道某个事情很难或几乎不可能完成,但仍然会尝试去做。这句话被用来形容那些敢于探索、勇于创新的人,尤其是那些在困难和挑战面前依然能够坚持不懈,不屈不挠,顽强奋斗的人。

我们无法根据现在的数据预测2500年后的情况,但我们可以通过信念主观改造现实

我们无法根据现在的数据预测2500年后的情况,但我们可以通过信念主观改造现实

德国哲学家海德格尔也有类似的观点,他在《存在与时间》里面提出了”向死而生(Being-toward-death)“这个概念。从一个独特的角度阐述了生命的意义。他提出,通过提高生命的效度和密度,做自己认为有价值的事情,生命才有意义。至于这件事能不能成,那是不重要的。

责任感,是指一个人对自己的行为、决策和影响负责的意识和能力。一个有责任感的人会尽力把事情做好。

责任感会让人放弃个人的利益而完成自己的角色需要做的事情。无论做这件事情在当时看来多么困难。

为了保护自己的孩子,这只鸟不计风险地挡在人的前面

为了保护自己的孩子,这只鸟不计风险地挡在人的前面

信念和责任感可以让人无视客观困难和风险而坚持做他们认为有意义有价值的事,哪怕会失去自己的生命也在所不辞。在某些情况下,他们的行为要么可以保全大家的利益,要么可以得到超额的收获。

主观意识决定物质是一个存在争议的论点,但是主观意识提升成功率是可以相信的。

在人类历史上,有很多人无视风险,为了自己认为正确的事情而舍生取义的事情。面对同样的情况,如果人工智能根据当时收集到的数据仔细计算风险的话,最后的结论很可能就是不值得做。

直觉与灵感

直觉与灵感是最难以解释的东西,当直觉起作用时,就像在游戏中作弊一样让本来极难的问题不讲道理般地得到解决。也许在规律在已知数据中存在时,人工智能可以通过分析海量数据我们可以最终找到这些规律,但是直觉和灵感的时间复杂度是O(1)。而当规律在已知数据中不存在时,基于数据的分析就无能为力了。

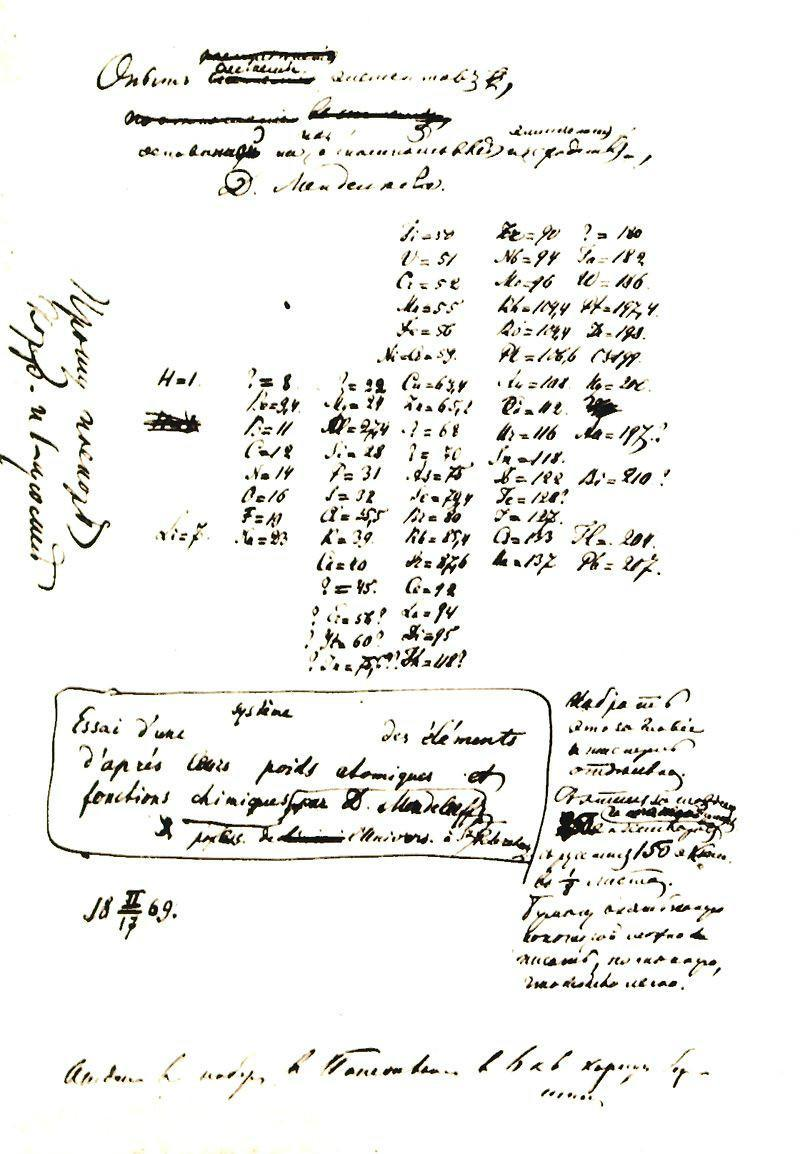

历史上有很多科学发现是通过直觉和灵感而获得的。如果不是做了一个奇怪的梦,门捷列夫无法发现元素周期表,凯斯勒也无法知道苯的环状结。

门捷列夫根据梦境记录的元素周期表

门捷列夫根据梦境记录的元素周期表

如果说物质世界的规律在理论是还可以在有限的时间内找到规律,那么非物质的数学就更加靠灵感和直觉了。

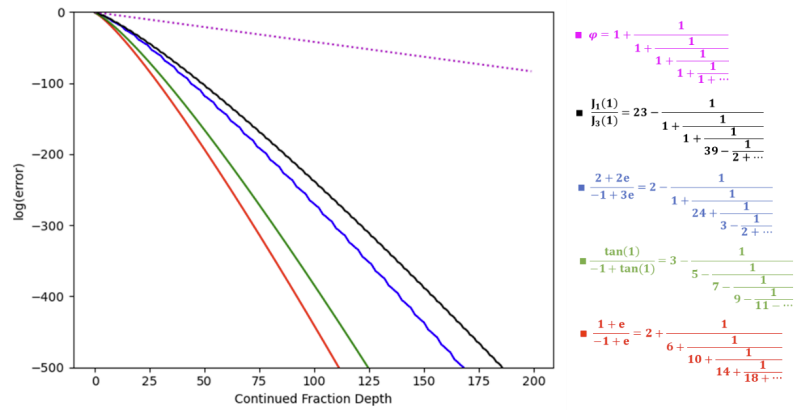

至今人们也不知道拉马努金是不讲道理地发明的那一大堆令人匪夷所思的公式。对很多公式他都没有留下证明,但后世的人发现他的公式都是对的。其中一些尚未被证明的公式,启发了几位菲尔兹奖得主的工作。

数学家哈代对拉马努金的评价体现出了这点:

他知识不足的程度跟知识的深厚都让人很吃惊。他是能够发现模方程和定理的人……到达前所未闻的地步,他对连分数的掌握……超出了世界上任何一个数学家,他自己发现了ζ函数的泛函方程和解析数论中的很多著名问题中级数的主要项;但他却没有听说过双周期函数或者柯西定理,对复变函数只有非常模糊的概念……

以色列理工学院曾在2019年提出一个叫做拉马努金机的算法来模仿拉马努金制造一些和连分数有关的公式,其本质仍然是通过”拟合“来增加连分数等式两边相等的概率。当算法认为误差足够低时,它便认为等式找到。这个算法可以找出两边无限逼近的连分数等式,但它仍然无法以数学的标准严格证明两边相等。

以色列理工大学用基于拟合的方法来发现连分数

以色列理工大学用基于拟合的方法来发现连分数

另一位数学家黎曼,更是一位理论超越观察的人。他的很多理论在提出时人们完全无法理解,有的理论直到现在人们也无法理解。但随着时间的推移,人们在现实世界中逐渐观察到可以用他的数学工具解释的现象。

比如黎曼在1854年提出了异于现实世界观察的黎曼几何。当时所有的现实问题都可以用已经用了上千年欧式几何解决。人们不知道这种新的几何除了思想游戏外还有什么作用。但是50年后,爱因斯坦成功地以黎曼几何为工具,才将广义相对论成功地用数学的方式表达。

如果是人工智能的话,是没法提出与所有观察数据相异的观点与结论的。

写在最后

通用人工智能没有明确的定义。

- 如果通用人工智能的定义是人工智能发展到能够淘汰或者征服人类,那么我觉得这只是个时间问题。因为达到这个门槛不需要人工智能在每一个方面都超越人类,或者具备意识。

- 如果通用人工智能的定义是人工智能可以取代人类做任何事情,那么我持怀疑态度。因为人具有主观能动性,具有数据无法支持的信念,以及具有有时能发挥作用的非理性。当然,我个人认为越来越多的人正逐渐失去自我塑造三观的能力。人类退化到失去灵性也不是没可能。

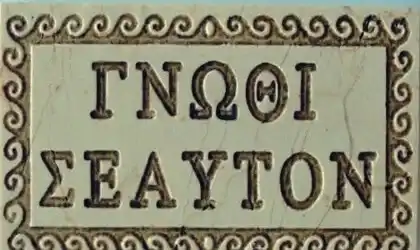

- 如果通用人工智能的定义是一个无所不知的智慧体,那么我持反对意见。刻在希腊德尔斐神庙的一句话“认识你自己”,在两千多年来一直提醒着我们人类自己:一个系统无法完备自洽,连具有灵性的人也不例外。

认识你自己

认识你自己

Leave a comment